أمازون روفوس: كيف قمنا ببناء مساعد تسوق مدعوم بالذكاء الاصطناعي

“ما الذي أحتاجه للعب الجولف في الطقس البارد؟”

“ما هي الاختلافات بين أحذية الدرب وأحذية الجري؟”

“ما هي أفضل ألعاب الديناصورات لطفل يبلغ من العمر خمس سنوات؟”

هذه بعض الأسئلة المفتوحة التي قد يطرحها العملاء على مساعد مبيعات مفيد في متجر فعلي. ولكن كيف يمكن للعملاء الحصول على إجابات لأسئلة مماثلة أثناء التسوق عبر الإنترنت؟

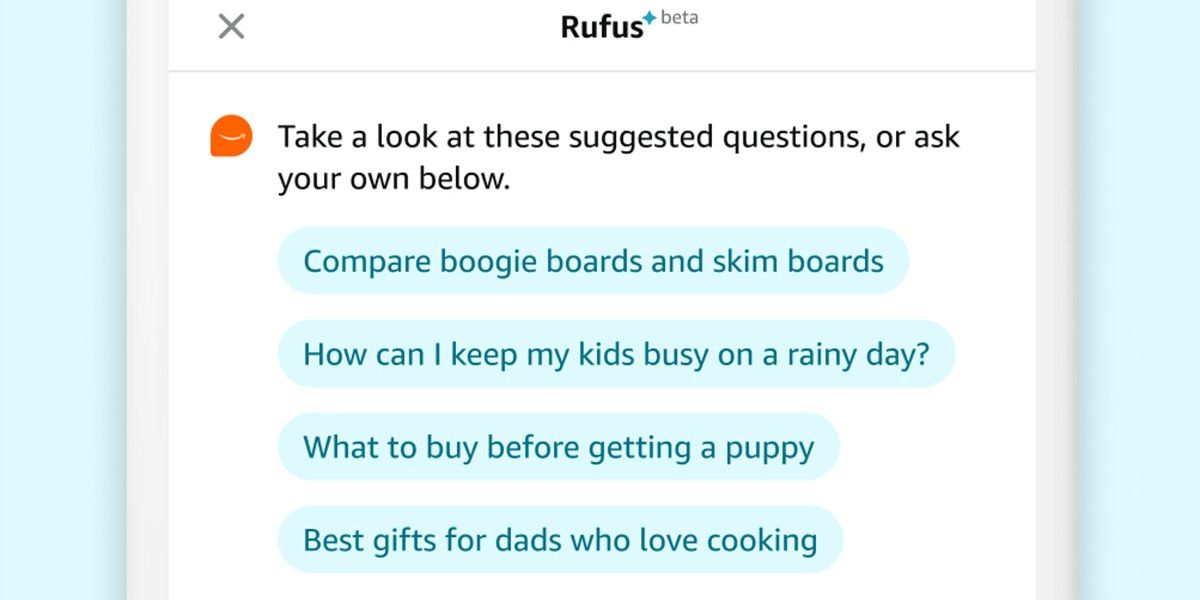

إجابة أمازون هي Rufus، وهو مساعد تسوق مدعوم بالذكاء الاصطناعي التوليدي. يساعد Rufus عملاء Amazon على اتخاذ قرارات تسوق أكثر استنارة من خلال الإجابة على مجموعة واسعة من الأسئلة داخل تطبيق Amazon. يمكن للمستخدمين الحصول على تفاصيل المنتج ومقارنة الخيارات وتلقي توصيات المنتج.

أنا أقود فريق العلماء والمهندسين الذين قاموا ببناء نموذج اللغة الكبير (LLM) الذي يدعم روفوس. لإنشاء مساعد تسوق تحادثي مفيد، استخدمنا تقنيات مبتكرة عبر جوانب متعددة من الذكاء الاصطناعي التوليدي. قمنا ببناء LLM مخصص للتسوق. استخدام تقنية الاسترجاع المعزز مع مجموعة متنوعة من مصادر الأدلة الجديدة؛ تعزيز التعلم المعزز لتحسين الاستجابات؛ وحققت تقدمًا في الحوسبة عالية الأداء لتحسين كفاءة الاستدلال وتقليل زمن الوصول؛ ونفذت بنية بث جديدة لتزويد المتسوقين بإجاباتهم بشكل أسرع.

كيف يحصل روفوس على الإجابات

يتم تدريب معظم حاملي شهادات LLM أولاً على مجموعة بيانات واسعة تُعلم المعرفة والقدرات الشاملة للنموذج، ثم يتم تخصيصها لمجال معين. لن ينجح ذلك مع Rufus، نظرًا لأن هدفنا كان تدريبه على بيانات التسوق منذ البداية — كتالوج Amazon بأكمله، كبداية، بالإضافة إلى مراجعات العملاء والمعلومات من منشورات الأسئلة والأجوبة في المجتمع. لذلك قام علماؤنا ببناء ماجستير إدارة أعمال مخصص تم تدريبه على مصادر البيانات هذه بالإضافة إلى المعلومات العامة على الويب.

ولكن لكي تكون مستعدًا للإجابة على مجموعة واسعة من الأسئلة التي يمكن طرحها، يجب تمكين Rufus لتجاوز بيانات التدريب الأولية الخاصة به وجلب معلومات جديدة. على سبيل المثال، للإجابة على السؤال: “هل هذه المقلاة آمنة للغسل في غسالة الأطباق؟” يقوم برنامج LLM أولاً بتحليل السؤال، ثم يحدد مصادر الاسترجاع التي ستساعده في توليد الإجابة.

يستخدم LLM الخاص بنا تقنية الاسترجاع المعزز (RAG) لسحب المعلومات من مصادر معروفة بأنها موثوقة، مثل كتالوج المنتجات، ومراجعات العملاء، ومنشورات الأسئلة والأجوبة المجتمعية؛ ويمكنه أيضًا الاتصال بواجهات برمجة تطبيقات متاجر أمازون ذات الصلة. إن نظام RAG الخاص بنا معقد للغاية، وذلك بسبب تنوع مصادر البيانات المستخدمة واختلاف أهمية كل منها، اعتمادًا على السؤال.

كل ماجستير في القانون، وكل استخدام للذكاء الاصطناعي التوليدي، هو عمل مستمر. لكي يتحسن Rufus بمرور الوقت، فإنه يحتاج إلى معرفة الاستجابات المفيدة وأيها يمكن تحسينها. العملاء هم أفضل مصدر لتلك المعلومات. تشجع أمازون العملاء على تقديم تعليقات Rufus، مما يسمح للنموذج بمعرفة ما إذا كانت الإجابة أعجبتهم أو لم تعجبهم، ويتم استخدام هذه الاستجابات في عملية التعلم المعزز. وبمرور الوقت، يتعلم Rufus من تعليقات العملاء ويحسن استجاباته.

الرقائق الخاصة وأساليب التعامل مع Rufus

يجب أن يكون Rufus قادرًا على التعامل مع ملايين العملاء في وقت واحد دون أي تأخير ملحوظ. يمثل هذا تحديًا كبيرًا نظرًا لأن تطبيقات الذكاء الاصطناعي التوليدية تتطلب حوسبة مكثفة للغاية، خاصة على نطاق أمازون.

لتقليل التأخير في إنشاء الاستجابات مع زيادة عدد الاستجابات التي يمكن لنظامنا التعامل معها أيضًا، لجأنا إلى شرائح الذكاء الاصطناعي المتخصصة من Amazon، Trainium وInferentia، والتي تم دمجها مع Amazon Web Services (AWS) الأساسية. لقد تعاونا مع AWS في التحسينات التي تعمل على تحسين كفاءة الاستدلال النموذجي، والتي تم إتاحتها بعد ذلك لجميع عملاء AWS.

لكن الطرق القياسية لمعالجة طلبات المستخدم على دفعات سوف تسبب مشاكل في زمن الوصول والإنتاجية لأنه من الصعب التنبؤ بعدد الرموز المميزة (في هذه الحالة، وحدات النص) التي ستنشئها LLM أثناء تأليف كل استجابة. عمل علماؤنا مع AWS لتمكين Rufus من استخدام الدفعة المستمرة، وهي تقنية LLM جديدة تمكن النموذج من بدء خدمة الطلبات الجديدة بمجرد انتهاء الطلب الأول في الدفعة، بدلاً من انتظار انتهاء جميع الطلبات في الدفعة. تعمل هذه التقنية على تحسين الكفاءة الحسابية لرقائق الذكاء الاصطناعي وتسمح للمتسوقين بالحصول على إجاباتهم بسرعة.

نريد من Rufus أن يقدم الإجابة الأكثر صلة وإفادة لأي سؤال محدد. في بعض الأحيان يعني ذلك إجابة نصية طويلة، ولكن في بعض الأحيان تكون عبارة عن نص قصير أو رابط قابل للنقر عليه للتنقل في المتجر. وكان علينا التأكد من أن المعلومات المقدمة تتبع التدفق المنطقي. إذا لم نقم بتجميع الأشياء وتنسيقها بشكل صحيح، فقد ينتهي بنا الأمر إلى الحصول على استجابة مربكة لا تكون مفيدة جدًا للعميل.

لهذا السبب يستخدم Rufus بنية تدفق متقدمة لتقديم الاستجابات. لا يحتاج العملاء إلى الانتظار حتى يتم إنشاء إجابة طويلة بالكامل، وبدلاً من ذلك، سيحصلون على الجزء الأول من الإجابة بينما يتم إنشاء الباقي. يقوم Rufus بملء استجابة البث بالبيانات الصحيحة (عملية تسمى الترطيب) عن طريق إجراء استعلامات للأنظمة الداخلية. بالإضافة إلى إنشاء محتوى الاستجابة، فإنه يقوم أيضًا بإنشاء تعليمات التنسيق التي تحدد كيفية عرض عناصر الإجابة المتنوعة.

على الرغم من أن أمازون تستخدم الذكاء الاصطناعي منذ أكثر من 25 عامًا لتحسين تجربة العملاء، فإن الذكاء الاصطناعي التوليدي يمثل شيئًا جديدًا وتحويليًا. نحن فخورون بـ Rufus والإمكانيات الجديدة التي توفرها لعملائنا.

من مقالات موقعك

مقالات ذات صلة حول الويب